A IA não erra sozinha, ela erra com base no que aprendeu

Autor: Renan Salinas

A Inteligência Artificial (IA) está deixando de ser apenas uma ferramenta de apoio e passando a ocupar um papel central nas decisões que moldam a vida das pessoas da concessão de crédito à contratação de funcionários, da definição de preços à priorização de atendimentos em serviços públicos e privados. O problema é que, à medida que os algoritmos decidem mais, cresce a dúvida: quem responde por essas decisões?

A resposta está na governança. Mais do que um conceito técnico, a governança de IA é um compromisso ético, jurídico e estratégico. Ela define como as empresas criam, testam, supervisionam e explicam os sistemas que usam para automatizar escolhas. É o que separa a inovação segura da inovação arriscada e, no futuro próximo, será o que separa empresas sustentáveis das que ficarão para trás.

O novo papel da governança

Durante anos, a IA foi vendida como sinônimo de eficiência. Hoje, o foco é outro: confiança. Em um mundo onde a tecnologia aprende, decide e recomenda, a confiança passa a ser o ativo mais valioso de uma marca.

Em 2025, o custo médio de uma violação de dados no Brasil atingiu R$ 7,19 milhões, um reflexo direto do uso crescente de tecnologias sem controle ou supervisão adequada. O dado revela um ponto essencial, a falta de governança custa caro em multas, danos à reputação e, principalmente, na perda de credibilidade junto ao cliente.

Governar a IA não é restringir o avanço tecnológico. É criar um conjunto de práticas que garantem transparência, rastreabilidade e supervisão humana. É fazer com que cada algoritmo tenha propósito, parâmetros claros e alguém responsável por suas consequências.

Decisões automatizadas exigem transparência

A Lei Geral de Proteção de Dados (LGPD) já dá o tom do que o futuro exige, que toda pessoa tem o direito de saber quando uma decisão que a afeta foi tomada por um sistema automatizado e de solicitar uma revisão humana. Isso muda tudo.

Empresas que automatizam decisões precisam estar preparadas para responder perguntas simples, mas profundas: por que esse cliente foi negado? Por que esse candidato não foi selecionado? Essas respostas só são possíveis quando há documentação, explicabilidade e registro de decisões.

Transparência, nesse contexto, significa explicar o processo, e não apenas o resultado; registrar as etapas de treinamento, uso e revisão do modelo e garantir uma via de contestação para o consumidor.

São medidas que reduzem riscos de vieses, evitam injustiças e fortalecem a cultura de responsabilidade dentro das organizações.

O risco invisível da automação descontrolada

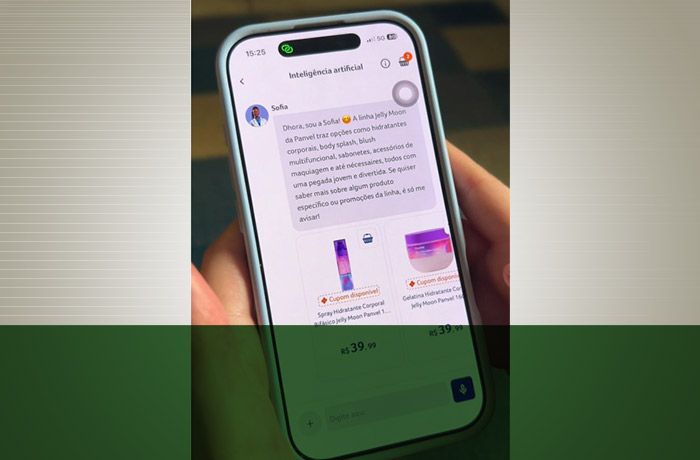

A IA não erra sozinha, ela erra com base no que aprendeu. Um sistema de recrutamento pode reproduzir preconceitos de gênero, um modelo de crédito pode penalizar bairros inteiros, um chatbot pode responder de forma discriminatória. São erros sutis, mas devastadores, que nascem da ausência de governança e da falta de diversidade nos dados e nas equipes que os criam.

De acordo com a McKinsey (2024), 40% das empresas globais afirmam ter acelerado o uso de IA nos últimos dois anos, mas menos da metade possui uma política formal de ética e governança. É o retrato de um avanço rápido e desordenado. Um cenário que pode gerar não apenas perdas financeiras, mas também erosão de confiança social.

A governança, portanto, é um antídoto para o improviso. Ela garante que a IA não apenas funcione, mas funcione de forma justa, segura e alinhada aos valores da organização e da sociedade.

Renan Salinas é CEO e founder da Yank Solutions.